@ -1,7 +1,7 @@

# 图像分类

本教程源代码目录在[book/image_classification](https://github.com/PaddlePaddle/book/tree/develop/03.image_classification),

本教程源代码目录在[book/image_classification](https://github.com/PaddlePaddle/book/tree/develop/03.image_classification), ,更多内容请参考本教程的[视频课堂](http://bit.baidu.com/course/detail/id/168.html) 。

## 背景介绍

@ -20,24 +20,25 @@

图像分类包括通用图像分类、细粒度图像分类等。图1展示了通用图像分类效果,

< p align = "center" >

< img src = "https://github.com/PaddlePaddle/book/blob/develop/03.image_classification/image/dog_cat.png?raw=true" width = "350" > < br / >

图1. 通用图像分类展示

< / p >

图2展示了细粒度图像分类-花卉识别的效果,要求模型可以正确识别花的类别。

< p align = "center" >

< img src = "https://github.com/PaddlePaddle/book/blob/develop/03.image_classification/image/flowers.png?raw=true" width = "400" > < br / >

图2. 细粒度图像分类展示

< / p >

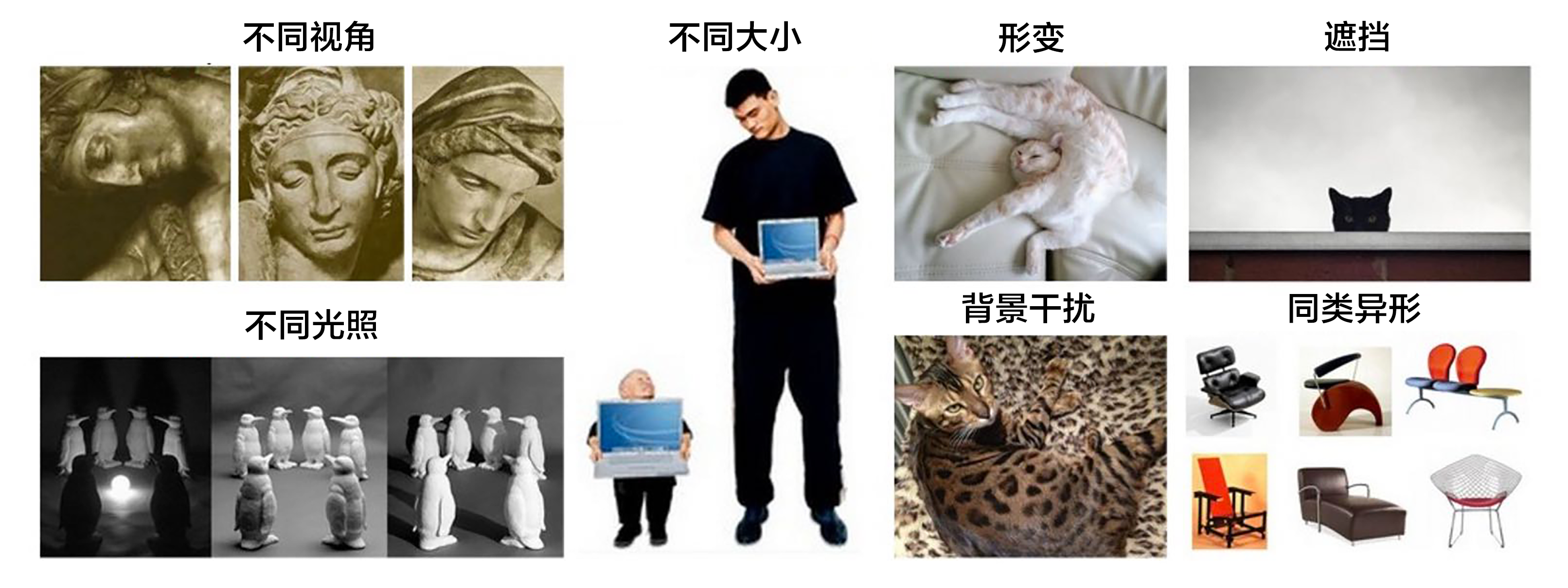

一个好的模型既要对不同类别识别正确,同时也应该能够对不同视角、光照、背景、变形或部分遮挡的图像正确识别(这里我们统一称作图像扰动)。图3展示了一些图像的扰动,

< p align = "center" >

< img src = "https://github.com/PaddlePaddle/book/blob/develop/03.image_classification/image/variations.png?raw=true" width = "550" > < br / >

图3. 扰动图片展示[22]

< / p >

@ -46,17 +47,21 @@

图像识别领域大量的研究成果都是建立在[PASCAL VOC](http://host.robots.ox.ac.uk/pascal/VOC/)、[ImageNet](http://image-net.org/)等公开的数据集上, ,

在2012年之前的传统图像分类方法可以用背景描述中提到的三步完成,

1). ** 底层特征提取**: 通常从图像中按照固定步长、尺度提取大量局部特征描述。常用的局部特征包括SIFT(Scale-Invariant Feature Transform, 尺度不变特征转换) \[[1 ](#参考文献 )\]、HOG(Histogram of Oriented Gradient, 方向梯度直方图) \[[2 ](#参考文献 )\]、LBP(Local Bianray Pattern, 局部二值模式) \[[3 ](#参考文献 )\] 等,一般也采用多种特征描述子,防止丢失过多的有用信息。

2). ** 特征编码**: 底层特征中包含了大量冗余与噪声,为了提高特征表达的鲁棒性,需要使用一种特征变换算法对底层特征进行编码,称作特征编码。常用的特征编码包括向量量化编码 \[[4 ](#参考文献 )\]、稀疏编码 \[[5 ](#参考文献 )\]、局部线性约束编码 \[[6 ](#参考文献 )\]、Fisher向量编码 \[[7 ](#参考文献 )\] 等。

3). ** 空间特征约束**: 特征编码之后一般会经过空间特征约束,也称作**特征汇聚**。特征汇聚是指在一个空间范围内,对每一维特征取最大值或者平均值,可以获得一定特征不变形的特征表达。金字塔特征匹配是一种常用的特征聚会方法,这种方法提出将图像均匀分块,在分块内做特征汇聚。

4). ** 通过分类器分类**: 经过前面步骤之后一张图像可以用一个固定维度的向量进行描述, ,

这种方法在PASCAL VOC竞赛中的图像分类算法中被广泛使用 \[[18 ](#参考文献 )\]。[NEC实验室](http://www.nec-labs.com/)在ILSVRC2010中采用SIFT和LBP特征, 8 ](#参考文献 )\]。

Alex Krizhevsky在2012年ILSVRC提出的CNN模型 \[[9 ](#参考文献 )\] 取得了历史性的突破, , , , , , , , ,

< p align = "center" >

< img src = "https://github.com/PaddlePaddle/book/blob/develop/03.image_classification/image/ilsvrc.png?raw=true" width = "500" > < br / >

图4. ILSVRC图像分类Top-5错误率

< / p >

@ -64,8 +69,8 @@ Alex Krizhevsky在2012年ILSVRC提出的CNN模型 \[[9](#参考文献)\] 取得

传统CNN包含卷积层、全连接层等组件, , ,

< p align = "center" >

< img src = "https://github.com/PaddlePaddle/book/blob/develop/03.image_classification/image/lenet.png?raw=true" > < br / >

图5. CNN网络示例[20]

< / p >

@ -83,8 +88,8 @@ Alex Krizhevsky在2012年ILSVRC提出的CNN模型 \[[9](#参考文献)\] 取得

牛津大学VGG(Visual Geometry Group)组在2014年ILSVRC提出的模型被称作VGG模型 \[[11 ](#参考文献 )\] 。该模型相比以往模型进一步加宽和加深了网络结构, , , , , , , , , 19 ](#参考文献 )\]就是借鉴VGG模型的结构。

< p align = "center" >

< img src = "https://github.com/PaddlePaddle/book/blob/develop/03.image_classification/image/vgg16.png?raw=true" width = "750" > < br / >

图6. 基于ImageNet的VGG16模型

< / p >

@ -92,12 +97,16 @@ Alex Krizhevsky在2012年ILSVRC提出的CNN模型 \[[9](#参考文献)\] 取得

GoogleNet \[[12 ](#参考文献 )\] 在2014年ILSVRC的获得了冠军, 13 ](#参考文献 )\] 和Inception模块, ,

NIN模型主要有两个特点: , , , ,

NIN模型主要有两个特点:

1) 引入了多层感知卷积网络(Multi-Layer Perceptron Convolution, MLPconv)代替一层线性卷积网络。MLPconv是一个微小的多层卷积网络, ,

2) 传统的CNN最后几层一般都是全连接层, ,

Inception模块如下图7所示, , , , , , , , ,

< p align = "center" >

< img src = "https://github.com/PaddlePaddle/book/blob/develop/03.image_classification/image/inception.png?raw=ture" width = "800" > < br / >

图7. Inception模块

< / p >

@ -105,8 +114,8 @@ GoogleNet由多组Inception模块堆积而成。另外,

GoogleNet整体网络结构如图8所示, : ; , , , ;

< p align = "center" >

< img src = "https://github.com/PaddlePaddle/book/blob/develop/03.image_classification/image/googlenet.jpeg?raw=true" > < br / >

图8. GoogleNet[12]

< / p >

@ -120,15 +129,15 @@ ResNet(Residual Network) \[[15](#参考文献)\] 是2015年ImageNet图像分类

残差模块如图9所示, , , , , ,

< p align = "center" >

< img src = "https://github.com/PaddlePaddle/book/blob/develop/03.image_classification/image/resnet_block.jpg?raw=true" width = "400" > < br / >

图9. 残差模块

< / p >

图10展示了50、101、152层网络连接示意图, ,

< p align = "center" >

< img src = "https://github.com/PaddlePaddle/book/blob/develop/03.image_classification/image/resnet.png?raw=true" > < br / >

图10. 基于ImageNet的ResNet模型

< / p >

@ -139,8 +148,8 @@ ResNet(Residual Network) \[[15](#参考文献)\] 是2015年ImageNet图像分类

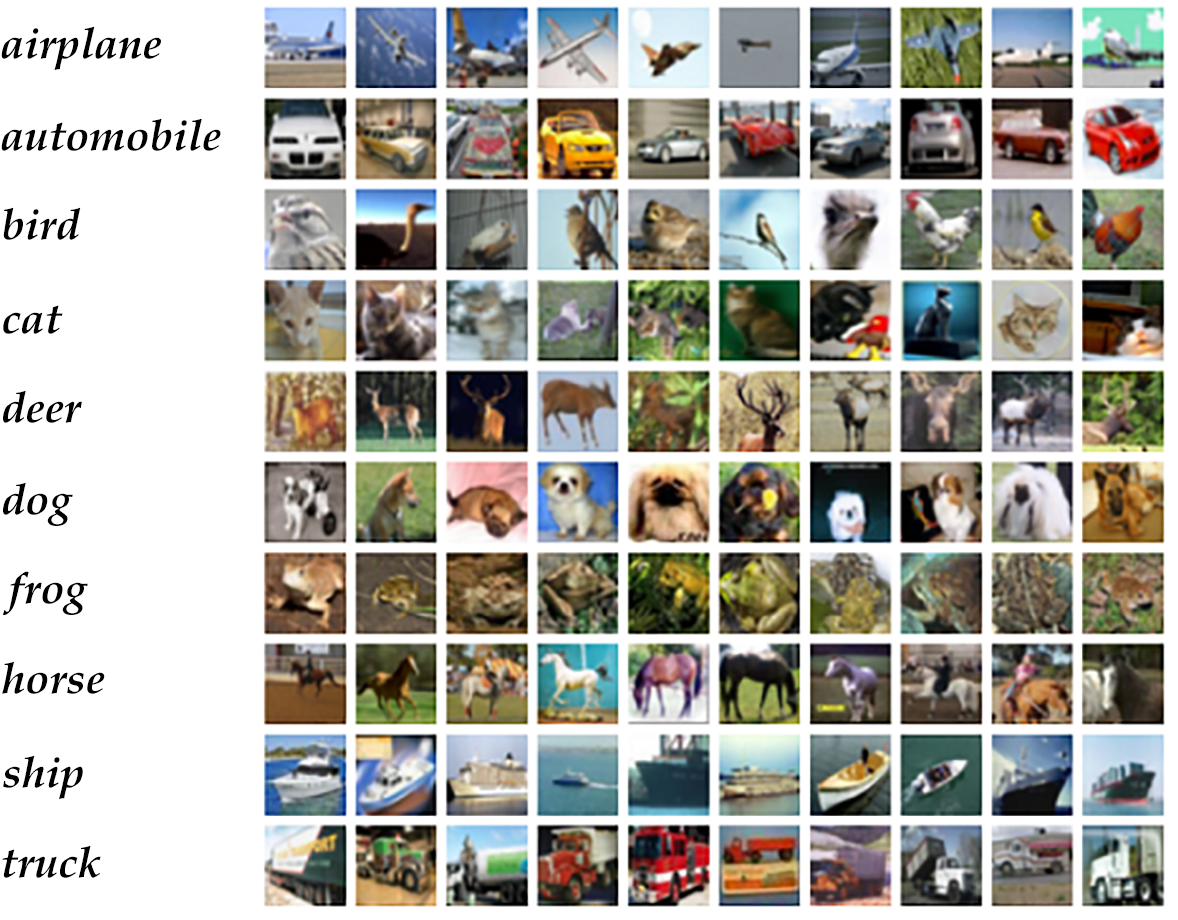

由于ImageNet数据集较大, , , < https: / / www . cs . toronto . edu / ~ kriz / cifar . html > )数据集。CIFAR10数据集包含60,000张32x32的彩色图片, , , ,

< p align = "center" >

< img src = "https://github.com/PaddlePaddle/book/blob/develop/03.image_classification/image/cifar.png?raw=true" width = "350" > < br / >

图11. CIFAR10数据集[21]

< / p >

@ -159,6 +168,7 @@ import paddle

import paddle.fluid as fluid

import numpy

import sys

from __future__ import print_function

```

本教程中我们提供了VGG和ResNet两个模型的配置。

@ -197,6 +207,7 @@ predict = fluid.layers.fc(input=fc2, size=10, act='softmax')

return predict

```

1. 首先定义了一组卷积网络, , , , ,

2. 五组卷积操作,即 5个conv_block。 第一、二组采用两次连续的卷积操作。第三、四、五组采用三次连续的卷积操作。每组最后一个卷积后面Dropout概率为0,

@ -260,10 +271,12 @@ return tmp

`resnet_cifar10` 的连接结构主要有以下几个过程。

1. 底层输入连接一层 `conv_bn_layer` ,

2. 然后连接3组残差模块即下面配置3组 `layer_warp` ,每组采用图 10 左边残差模块组成。

3. 最后对网络做均值池化并返回该层。

注意:除过第一层卷积层和最后一层全连接层之外,要求三组 `layer_warp` 总的含参层数能够被6整除, `resnet_cifar10` 的 depth 要满足 ` ` 。

注意:除过第一层卷积层和最后一层全连接层之外,要求三组 `layer_warp` 总的含参层数能够被6整除, `resnet_cifar10` 的 depth 要满足 $(depth - 2) % 6 == 0$ 。

```python

def resnet_cifar10(ipt, depth=32):

@ -363,7 +376,11 @@ paddle.dataset.cifar.test10(), batch_size=BATCH_SIZE)

`event_handler_plot` 可以用来利用回调数据来打点画图:

< p align = "center" >

< img src = "https://github.com/PaddlePaddle/book/blob/develop/03.image_classification/image/train_and_test.png?raw=true" width = "350" > < br / >

图12. 训练结果

< / p >

```python

params_dirname = "image_classification_resnet.inference.model"

@ -425,7 +442,7 @@ trainer.save_params(params_dirname)

通过`trainer.train`函数训练:

**注意:** CPU, ~ , , 培 训速度。

**注意:** CPU, ~ , , 练 速度。

```python

trainer.train(

@ -449,11 +466,11 @@ Pass 300, Batch 0, Cost 1.223424, Acc 0.593750

Test with Pass 0, Loss 1.1, Acc 0.6

```

图12 是训练的分类错误率曲线图, ,

图13 是训练的分类错误率曲线图, ,

< p align = "center" >

图12. CIFAR10数据集上VGG模型的分类错误率

< img src = "https://github.com/PaddlePaddle/book/blob/develop/03.image_classification/image/plot.png?raw=true" width = "400" > < br / >

图13. CIFAR10数据集上VGG模型的分类错误率

< / p >

## 应用模型

@ -498,10 +515,10 @@ img = load_image(cur_dir + '/image/dog.png')

```python

inferencer = fluid.Inferencer(

infer_func=inference_program, param_path=params_dirname, place=place)

label_list = ["airplane", "automobile", "bird", "cat", "deer", "dog", "frog", "horse", "ship", "truck"]

# inference

results = inferencer.infer({'pixel': img})

print("infer results: ", results)

print("infer results: %s " % label_list[np.argmax( results[0])] )

```

## 总结